Video: Hvad kan du gøre med en webcrawler?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Webcrawlere bruges hovedsageligt til at oprette en kopi af alle de besøgte sider til senere behandling af en søgemaskine, dvs vilje indeksere de downloadede sider for at give hurtige søgninger. Crawlere kan også bruges til automatisering af vedligeholdelsesopgaver Web websted, såsom kontrol af links eller validering af HTML-kode.

På samme måde, hvordan fungerer en webcrawler?

EN crawler er et program, der besøger Web websteder og læser deres sider og anden information for at oprette poster til et søgemaskineindeks. Crawlere tilsyneladende fået navnet, fordi de kravle gennem en sitea-side ad gangen ved at følge links til andre sider på sitet, indtil alle sider er blevet læst.

hvad er webcrawling og -skrabning? Kravler refererer normalt til at beskæftige sig med store datasæt, hvor du udvikler dine egne crawlere (eller bots), som kravle til det dybeste af web sider. Data skrabning på den anden side henviser til at hente information fra enhver kilde (ikke nødvendigvis web ).

Heraf, hvad kan du være sikker på, at alle webcrawlere og hjælpeteknologi vil behandle?

Webcrawlere kopiere sider til forarbejdning af en søgemaskine, som indekserer de downloadede sider, så brugerne kan søge mere effektivt. Crawlere kan valider hyperlinks og HTML-kode. De kan også bruges til web skrabning (se også datadrevet programmering).

Hvilken teknologi bruger søgemaskiner til at crawle websites bots?

En webcrawler eller edderkop er en type bot der typisk drives af søgemaskiner som Google og Bing. Deres formål er at indeksere indholdet af websteder hele internettet, så de hjemmesider kan dukke op i søgemaskine resultater.

Anbefalede:

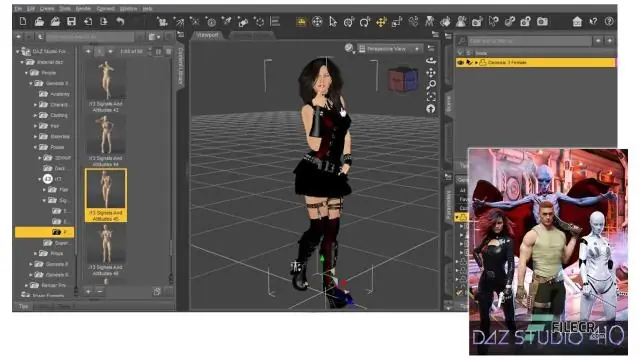

Hvad kan du gøre med DAZ Studio?

DAZ Studio er grundlæggende: Til POSERING af figurer. Oprettelse af animationer. Gengivelse af de endelige resultater (jpgs, pngs, film osv.) Rigging og vægtkortlægningsfigurer. Saml dine scener sammen

Hvad kan du gøre med gamle Raspberry Pi?

Hvad skal du gøre med din gamle Pi, efter at Raspberry Pi 4 er udgivet? 1 Prøv et andet Smart Home-system. 2 Geninstaller det som et Smart Home System til en ven eller et familiemedlem. 3 Vend din gamle hindbær i en retro-gaming-maskine. 4 Gør det til et mediecenter. 5 Gør den til en NAS

Hvad kan jeg gøre med en trim router?

10 værkstedsanvendelser til en trimfræser Trimfræseren er et værktøj, der måske ikke bliver brugt meget i nogle butikker, men det er unikt og overraskende alsidigt værktøj. #1 - Duplikering af dele. #2 - Skæring af hængselboringer. #3 - Profileringskanter. #4 - Rengøringsfiner. #5 - Trimning af hyldekant. #6 - Skylleskærepropper. #7 - Snedkeri

Hvad kan jeg gøre med Apache?

En webserver såsom Apache Http Server kan udføre mange opgaver. Disse omfatter omskrivningsregler, virtuel hosting, mod sikkerhedskontrol, omvendt proxy, SSL-verifikation, godkendelse og autorisation og mange flere afhængigt af dine behov og ønsker

Hvad kan du gøre med gradle?

Gradle gør det muligt at administrere klassestien for dine projekter. Det kan tilføje JAR-filer, mapper eller andre projekter til byggestien til din applikation. Det understøtter også automatisk download af dine Java-biblioteksafhængigheder. Du skal blot angive afhængigheden i din Gradle build-fil