Video: Kan Spark læse lokale filer?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Mens Gnist understøtter læsning filer fra lokal filsystem, kræver det, at filer er tilgængelige på samme sti på alle noder i din klynge. Nogle netværksfilsystemer, såsom NFS, AFS og MapR's NFS-lag, er eksponeret for brugeren som et almindeligt filsystem.

Efterfølgende kan man også spørge, hvordan kører jeg spark i lokal tilstand?

I Lokal tilstand , gnist job løb på en enkelt maskine og udføres parallelt ved hjælp af multi-threading: dette begrænser paralleliteten til (højst) antallet af kerner i din maskine. Til løb job i Lokal tilstand , skal du først reservere en maskine gennem SLURM i interaktiv mode og logge ind på den.

Udover ovenstående, hvad er SC textFile? tekstfil er en metode til en org. apache. SparkContext klasse, der læser a tekstfil fra HDFS, et lokalt filsystem (tilgængeligt på alle noder) eller enhver Hadoop-understøttet filsystem-URI, og returner den som en RDD af strenge.

Hvad er i denne forbindelse en gnistfil?

Det Spark-fil er et dokument, hvor du opbevarer al din kreative godhed. Det blev defineret af forfatteren Stephen Johnson. Så i stedet for at ridse noter ned på en Post-it® midt om natten eller afsætte forskellige journaler til ideer, samler du alle dine koncepter i én fil.

Hvad er paralleliseret samlingsgnist?

Vi beskriver operationer på distribuerede datasæt senere. Parallellede samlinger oprettes ved at kalde JavaSparkContext 's parallelisere metode på en eksisterende Kollektion i dit driverprogram. Elementerne i kollektion kopieres til et distribueret datasæt, der kan betjenes parallelt.

Anbefalede:

Kan Python læse ZIP-filer?

For at arbejde med zip-filer ved hjælp af python, vil vi bruge et indbygget python-modul kaldet zipfile. print ('Done!' ZipFile er en klasse af zipfile modul til læsning og skrivning af zip-filer. Her importerer vi kun klasse ZipFile fra zipfile modul

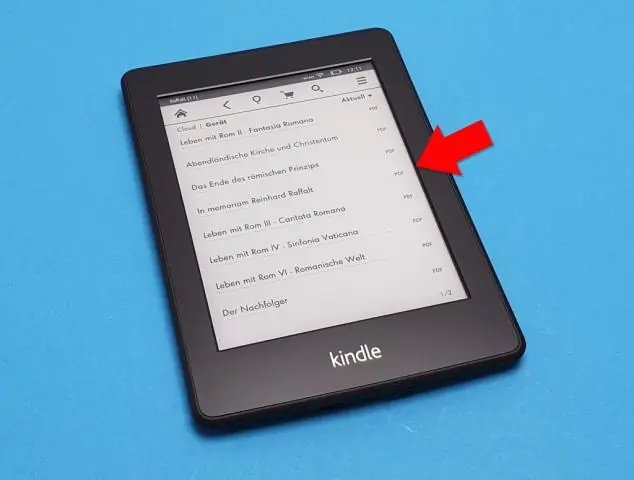

Kan finale læse PDF-filer?

Pro-tip: Du kan også åbne filen i Finale ved at vælge filen i din finder og højreklikke. Vælg derefter "Åbn med…", og vælg Finale i programlinjen. Tillykke! Du har med succes importeret en PDF-fil til Finale ved hjælp afScanScore

Kan Nook læse PDF-filer?

Dokumenter, som du kan tilføje til Nookinclude PDF'er, som kan være bøger eller andre kortere dokumenter. PDF'er på Nook kan læses ligesom enhver anden købt bog, og du kan synkronisere enheden ved at kopiere dokumenterne fra din computer til Nook. Dobbeltklik på mappen "Books" eller "Documents" på din Nook's drev

Kan Python læse.MAT-filer?

Fra og med release 7.3 af Matlab, gemmes mat-filer faktisk ved at bruge HDF5-formatet som standard (undtagen hvis du bruger -vX-flaget på sparetidspunktet, se i Matlab). Disse filer kan læses i Python ved hjælp af for eksempel PyTables eller h5py-pakken

Kan Windows læse HEIC-filer?

HEIF Image Extension gør det muligt for Windows 10-enheder at læse og skrive filer, der bruger HEIF-formatet (HighEfficiency Image File). Sådanne filer kan have en. heic eller. Hvis HEVC Video Extensions-pakken ikke er installeret, vil HEIF Image Extension ikke være i stand til at læse eller skrive