Video: Hvordan virker selvopmærksomhed?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

I lægmandssprog selv - opmærksomhed mekanisme tillader inputs at interagere med hinanden (" selv ”) og find ud af, hvem de skal betale mere opmærksomhed til (" opmærksomhed ”). Udgangene er aggregater af disse interaktioner og opmærksomhed scoringer.

Og hvad er selvopmærksomhed?

Selv - opmærksomhed , nogle gange kaldet intra- opmærksomhed er en opmærksomhed mekanisme, der relaterer forskellige positioner af en enkelt sekvens for at beregne en repræsentation af sekvensen.

Og hvad er selvopmærksomhed i dyb læring? Lad os først definere, hvad " selv - Opmærksomhed ” er. Cheng et al, i deres papir med navnet "Long Short-Term Memory-Networks for Maskine Læsning”, defineret selv - Opmærksomhed som mekanismen til at relatere forskellige positioner af en enkelt sekvens eller sætning for at få en mere levende repræsentation.

Med hensyn til dette, hvad er opmærksomhedsmekanisme?

Opmærksomhedsmekanisme tillader dekoderen at behandle forskellige dele af kildesætningen ved hvert trin af outputgenereringen. I stedet for at indkode inputsekvensen til en enkelt fast kontekstvektor, lader vi modellen lære, hvordan man genererer en kontekstvektor for hvert outputtidstrin.

Hvad er opmærksomhedsbaseret model?

Opmærksomhed - baserede modeller tilhører en klasse af modeller almindeligvis kaldet sekvens-til-sekvens modeller . Formålet med disse modeller , som navnet antyder, det at producere en output-sekvens givet en input-sekvens, som generelt er af forskellig længde.

Anbefalede:

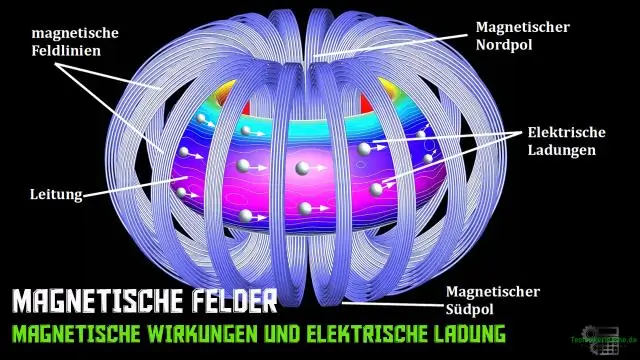

Hvordan virker magnetiske sikkerhedsstrimler?

Strimlen er foret magnetisk materiale med en moderat magnetisk 'hårdhed'. Detektion finder sted, når harmoniske og signaler, der genereres af materialets magnetiske respons under lavfrekvente magnetfelter, registreres. Når det ferromagnetiske materiale magnetiseres, tvinger det den amorfe metalstrimmel til mætning

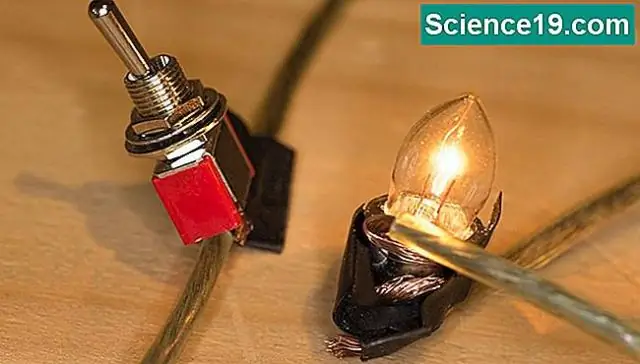

Hvordan virker lamper, som du rører ved for at tænde?

Det betyder, at hvis et kredsløb forsøgte at oplade lampen med elektroner, ville det tage et vist antal at 'fylde den'. Når du rører ved lampen, øger din krop dens kapacitet. Det kræver flere elektroner at fylde dig og lampen, og kredsløbet registrerer den forskel

Hvordan virker rokkenheden?

StingRay er en IMSI-fanger med både passiv (digital analysator) og aktiv (celle-site simulator) funktioner. Når den opererer i aktiv tilstand, efterligner enheden et trådløst operatørcelletårn for at tvinge alle nærliggende mobiltelefoner og andre mobildataenheder til at oprette forbindelse til det

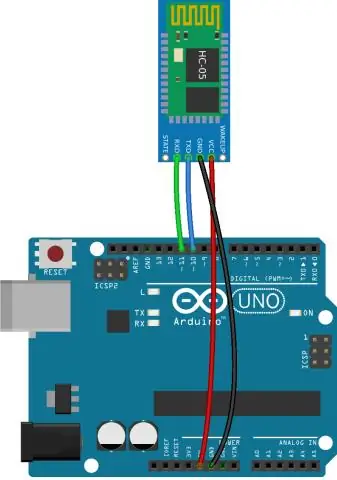

Hvordan virker Bluetooth-modul HC 05?

HC-05 Bluetooth Module er et brugervenligt Bluetooth SPP (Serial Port Protocol) modul, designet til transparent trådløs seriel forbindelsesopsætning. HC-05 Bluetooth-modul giver skifttilstand mellem master- og slavetilstand, hvilket betyder, at det hverken kan bruge til at modtage eller sende data

Hvordan virker SQL undtagen?

SQL - UNDTAGET Klausul. SQL EXCEPT-sætningen/operatoren bruges til at kombinere to SELECT-sætninger og returnerer rækker fra den første SELECT-sætning, som ikke returneres af den anden SELECT-sætning. Dette betyder, at EXCEPT kun returnerer rækker, som ikke er tilgængelige i den anden SELECT-sætning