Video: Hvordan bruges Hadoop i dataanalyse?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Hadoop er en open source softwareramme, der giver mulighed for behandling af store data sæt på tværs af klynger af computere ved hjælp af simple programmeringsmodeller. Hadoop er designet til at skalere op fra enkelte servere til tusindvis af maskiner.

Heri, hvad er Hadoop i dataanalyse?

Hadoop . Hadoop er et sæt open source-programmer skrevet i Java, som kan bruges til at udføre operationer på en stor mængde data . Hadoop er et skalerbart, distribueret og fejltolerant økosystem. Hadoop MapReduce = bruges til at indlæse data fra en database, formatere den og udføre en kvantitativ analyse på det.

hvorfor bruges Hadoop til big data-analyse? Hadoop er en open source-softwareramme til lagring data og kører applikationer på klynger af råvarehardware. Det giver massiv opbevaring til enhver form for data , enorm processorkraft og evnen til at håndtere stort set ubegrænsede samtidige opgaver eller job.

Hvad er så funktionerne i Apache Hadoop i dataanalyse?

Apache Hadoop software er en kraftfuld ramme til at muliggøre distribuerede behandlingsformål for store datasæt på tværs af flere klynger af computere. Det er designet til at skalere op fra enkelte servere til tusindvis af servermaskiner. Dette mål anses for at give lokal beregning og lagring af hver server.

Er Hadoop en datavidenskab?

Svaret på dette spørgsmål er et stort JA! Datavidenskab er et stort felt. Hovedfunktionaliteten af Hadoop er opbevaring af Big Data . Det giver også brugerne mulighed for at gemme alle former for data , altså både struktureret data og ustruktureret data . Hadoop leverer også moduler som Pig og Hive til analyse i stor skala data.

Anbefalede:

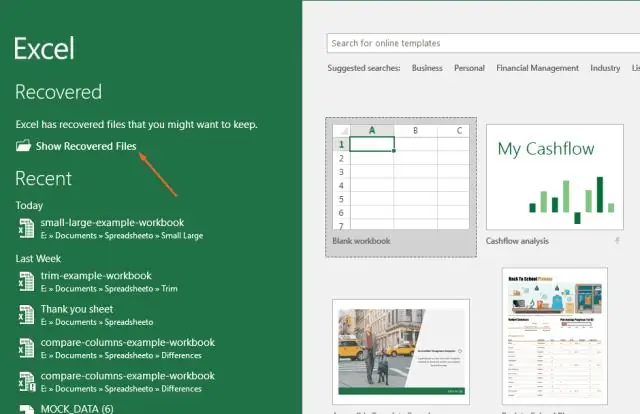

Hvordan åbner jeg dataanalyse i Excel 2007?

Excel 2007: Data Analysis-tilføjelsen skal vises i højre ende af menuen Data som DataAnalysis. Klik på Microsoft Office-knappen, og klik derefter på Excel-indstillinger. Klik på Tilføjelsesprogrammer, og vælg derefter Excel-tilføjelsesprogrammer i feltet Administrer. Klik på Gå

Hvordan laver man dataanalyse i R?

I dette indlæg vil vi gennemgå nogle funktioner, der fører os til analysen af det første tilfælde. Trin 1 – Første tilgang til data. Trin 2 – Analyse af kategoriske variable. Trin 3 – Analyse af numeriske variable. Trin 4 – Analyse af numerisk og kategorisk på samme tid

Hvordan får du dataanalyse på Excel 2011 til Mac?

Marker afkrydsningsfeltet AnalysisToolPak - VBA i feltet Add-ins tilgængelige. Bemærk: Analysis ToolPak er ikke tilgængelig for Excel til Mac 2011. Indlæs Analysis ToolPak i Excel Klik på fanen Filer, klik på Indstillinger, og klik derefter på tilføjelseskategorien. I feltet Administrer skal du vælge Excel-tilføjelser og derefter klikke på Gå

Hvordan bruger virksomheder dataanalyse i deres virksomhed?

Big data-analyse involverer at undersøge store mængder data. Dette gøres for at afdække de skjulte mønstre, sammenhænge og også for at give indsigt for at træffe rigtige forretningsbeslutninger. Grundlæggende ønsker virksomheder at være mere objektive og datadrevne, og derfor omfavner de kraften i data og teknologi

Hvordan bruges dataanalyse i sport?

Der er to nøgleaspekter af sportsanalyse - analyse på banen og uden for banen. Analyse på banen beskæftiger sig med at forbedre præstationerne på banen for hold og spillere. Off-field analytics bruger i det væsentlige data til at hjælpe rettighedshaverne med at tage beslutninger, der ville føre til højere vækst og øget rentabilitet