Video: Hvordan opnås datalokalisering i Hadoop?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Data lokalisering i Hadoop . Tag eksemplet med Wordcount-eksemplet, hvor de fleste af ordene er blevet gentaget i 5 Lacs eller flere gange. I så fald efter Mapper-fasen vil hvert Mapper-output have ord i intervallet 5 Lacs. Denne komplette proces med lagring af Mapper-output til LFS kaldes som Datalokalisering.

Med dette i øjesyn, hvad er datalokalisering i Hadoop?

Begrebet Data lokalitet i Hadoop data lokalitet i KortReducer refererer til evnen til at flytte beregningen tæt på hvor den faktiske data ligger på knudepunktet, i stedet for at bevæge sig stort data til beregning. Dette minimerer overbelastning af netværket og øger systemets samlede gennemløb.

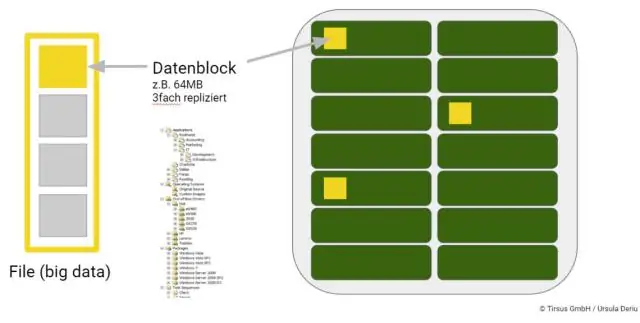

Og hvordan opbevares big data? De fleste mennesker forbinder automatisk HDFS eller Hadoop Distributed File System med Hadoop data varehuse. HDFS gemmer information i klynger, der består af mindre blokke. Disse blokke er gemt i fysisk på stedet opbevaring enheder, såsom interne diskdrev.

Bare så, hvordan opbevares data i Hadoop?

På en Hadoop klynge, den data inden for HDFS og MapReduce-systemet er placeret på hver maskine i klyngen. Data er gemt i data blokke på DataNodes. HDFS replikerer dem data blokke, normalt 128 MB i størrelse, og distribuerer dem, så de replikeres inden for flere noder på tværs af klyngen.

Hvordan lagres filer i HDFS?

HDFS afslører en fil systemnavneområde og tillader brugerdata at være gemt i filer . Internt, a fil er opdelt i en eller flere blokke, og disse blokke er gemt i et sæt DataNodes. NameNode udføres fil systemnavnefunktioner som åbning, lukning og omdøbning filer og mapper.

Anbefalede:

Hvordan opnås konsensus i Blockchain?

Hvad er en konsensusmekanisme? En konsensusmekanisme er en fejltolerant mekanisme, der bruges i computer- og blockchain-systemer til at opnå den nødvendige enighed om en enkelt dataværdi eller en enkelt tilstand af netværket blandt distribuerede processer eller multi-agent-systemer, såsom med kryptovalutaer

Hvordan virker HBase i Hadoop?

HBase er en datamodel, der ligner Googles store tabel, der er designet til at give tilfældig adgang til store mængder strukturerede eller ustrukturerede data. HBase er en vigtig komponent i Hadoop-økosystemet, der udnytter fejltolerancefunktionen i HDFS. HBase giver læse- eller skriveadgang i realtid til data i HDFS

Hvordan opnås multithreading i Python?

Med gevindskæring opnås samtidighed ved brug af flere tråde, men på grund af GIL kan kun én tråd køres ad gangen. I multiprocessing er den originale proces forgrenet proces til flere underordnede processer, der omgår GIL. Hver underordnede proces vil have en kopi af hele programmets hukommelse

Hvordan bliver jeg Hadoop-administrator?

Trin til at blive Hadoop-administrator Forstå de grundlæggende og karakteristika ved Big Data, og brug dem til at hjælpe organisationer med at administrere Big Data. Arbejd med Hadoop-klienter og webgrænseflader. Brug klyngeplanlægning og værktøjer til dataindtastning i Hadoop-klynger. Brug Hadoop-komponenter i Hadoop-økosystemet

Hvordan opretter jeg en mappe i Hadoop filsystem?

Opret en mappe i HDFS. Anvendelse: $ hdfs dfs -mkdir Liste indholdet af en mappe i HDFS. Upload en fil til HDFS. Download en fil fra HDFS. Kontroller en filtilstand i HDFS. Se indholdet af en fil i HDFS. Kopier en fil fra kilde til destination i HDFS. Kopier en fil fra/til det lokale filsystem til HDFS