Video: Hvad er række i PySpark?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

EN række i SchemaRDD. Felterne i den kan tilgås som attributter. Række kan bruges til at skabe en række objekt ved at bruge navngivne argumenter, vil felterne blive sorteret efter navne.

Og hvad er der med Column Pyspark?

Gnist med kolonne ()-funktionen bruges til at omdøbe, ændre værdien, konvertere datatypen for en eksisterende DataFrame-kolonne og kan også bruges til at oprette en ny kolonne, i dette indlæg vil jeg lede dig gennem almindeligt anvendte DataFrame-kolonneoperationer med Scala og Pyspark eksempler.

Også, hvordan viser du DataFrame i Pyspark? Der er typisk tre forskellige måder, du kan bruge til at udskrive indholdet af datarammen:

- Udskriv Spark DataFrame. Den mest almindelige måde er at bruge show()-funktionen: >>> df.

- Udskriv Spark DataFrame lodret.

- Konverter til Pandas og udskriv Pandas DataFrame.

På samme måde kan du spørge, hvad er Pyspark?

PySpark Programmering. PySpark er et samarbejde mellem Apache Spark og Python. Apache Spark er en open source-klyngecomputerramme, bygget op omkring hastighed, brugervenlighed og streaminganalyse, hvorimod Python er et generelt programmeringssprog på højt niveau.

Hvordan tilmelder jeg mig Pyspark?

Resumé: Pyspark DataFrames har en tilslutte metode, som tager tre parametre: DataFrame på højre side af tilslutte , Hvilke felter samles på, og hvilken type tilslutte (indre, ydre, venstre_ydre, højre_ydre, venstresemi). Du ringer til tilslutte metode fra venstre side DataFrame-objekt såsom df1. tilslutte (df2, df1.

Anbefalede:

Hvad er bred række i Cassandra?

Rækker kan beskrives som tynde eller brede. Mager række: har et fast, relativt lille antal kolonnenøgler. Bred række: har et relativt stort antal kolonnenøgler (hundrede eller tusinder); dette tal kan stige, efterhånden som nye dataværdier indsættes

Hvad er en enkelt række underforespørgsel?

Enkelt række underforespørgsler. En enkelt række underforespørgsel returnerer nul eller én række til den ydre SQL-sætning. Du kan placere en underforespørgsel i en WHERE-sætning, en HAVING-sætning eller en FROM-sætning i en SELECT-sætning

Hvad er række- og kolonnelager i SAP HANA?

I en kolonnelagertabel gemmes data lodret. I en konventionel database lagres data i Row-baseret struktur, dvs. horisontalt. SAP HANA gemmer data i både række- og kolonnebaserede strukturer. Dette giver ydeevneoptimering, fleksibilitet og datakomprimering i HANA-databasen

Hvad er en række strukturer?

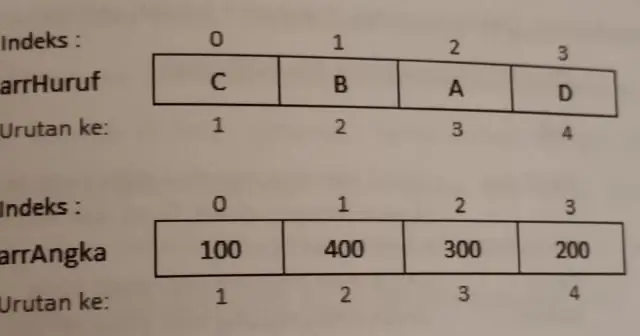

Vifte af strukturer. I programmering er struktur en sammensat datatype med en samling af variable. Disse variabler kan have forskellige datatyper og tilsammen danne en struktur af en sammensat datatype. En række strukturer er en sekventiel samling af strukturer

Hvad er en række objekter i JavaScript?

JavaScript - Arrays-objektet. Array-objektet lader dig gemme flere værdier i en enkelt variabel. Den gemmer en sekventiel samling af fast størrelse af elementer af samme type. Et array bruges til at gemme en samling af data, men det er ofte mere nyttigt at tænke på et array som en samling af variabler af samme type