Video: Hvorfor er træningsfejl mindre end testfejl?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Det træningsfejl vil normalt være Mindre end det test fejl fordi de samme data, der bruges til at passe til modellen, bruges til at vurdere dens træningsfejl . En del af uoverensstemmelsen mellem træningsfejl og test fejl er fordi uddannelse sæt og prøve sæt har forskellige inputværdier.

Er valideringsfejlen derfor altid højere end træningsfejlen?

Men generelt set, træningsfejl vil næsten altid undervurder din valideringsfejl . Det er dog muligt for valideringsfejl at være mindre end træningen . Du kan tænke på det på to måder: Din uddannelse set havde mange 'svære' sager at lære.

Og hvorfor øges træningsfejlen? Imidlertid fejl på testsættet falder kun, da vi tilføjer fleksibilitet op til et vist punkt. I dette tilfælde sker det ved 5 grader som fleksibiliteten stiger ud over dette punkt træningsfejl stiger fordi modellen har husket uddannelse data og støj.

På samme måde kan du spørge, hvad er træningsfejl og testfejl?

Træningsfejl opstå, når en trænet model vender tilbage fejl efter at have kørt det på dataene igen. Det begynder at returnere forkert resultater. Test fejl er dem, der sker, når en trænet modellen køres på et datasæt, som den ikke har nogen idé om. Det vil sige uddannelse data er helt anderledes end afprøvning data.

Hvorfor er valideringsnøjagtigheden højere end træningsnøjagtigheden?

Det uddannelse tab er højere fordi du har gjort det kunstigt sværere for netværket at give de rigtige svar. Dog under validering alle enheder er tilgængelige, så netværket har sin fulde regnekraft - og dermed kan det yde bedre end i uddannelse.

Anbefalede:

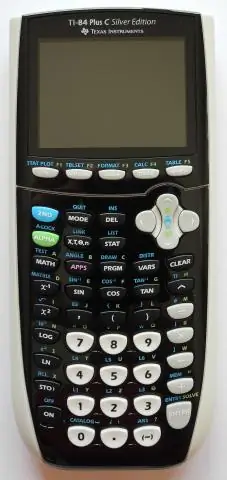

Hvordan får du mindre end tegn på TI 84?

Ti-84 Plus Graphing Calculator For Dummies, 2nd Edition Brug piletasterne til at placere markøren på tegnet for den funktion eller ulighed, du definerer. Tryk på [ALPHA] og tryk på tasten under det relevante ligheds- eller ulighedssymbol. For at få det første skærmbillede skal du trykke på [ALPHA][ZOOM] for at indtaste et mindre-end- eller lighedstegn

Hvorfor er symmetrisk kryptering hurtigere end asymmetrisk kryptering?

For standard kryptere/dekryptere funktioner fungerer symmetriske algoritmer generelt meget hurtigere end deres asymmetriske modstykker. Dette skyldes det faktum, at asymmetrisk kryptografi er massivt ineffektiv. Symmetrisk kryptografi er designet præcist til effektiv behandling af store mængder data

Hvorfor er en flad database mindre effektiv end en relationsdatabase?

En enkelt flad-fil tabel er nyttig til at registrere en begrænset mængde data. Men en stor flad-fil-database kan være ineffektiv, da den optager mere plads og hukommelse end en relationel database. Det kræver også, at der tilføjes nye data, hver gang du indtaster en ny post, hvorimod en relationsdatabase ikke gør det

Hvilken størrelse er mindre end 7 16?

Størrelser på skruenøgle er lidt nemmere at finde ud af end fatningsstørrelser, da du ikke har at gøre med forskellige skraldedrevstørrelser. Størrelsesskema for skruenøgle til bolte. Boltdiameter Skruenøglestørrelse (Standard) Skruenøglestørrelse (metrisk) 1/8' 5/16' 8mm 3/16' 3/8' 10mm 1/4' 7/16' 11mm 5/16' 1/2' 13mm

Hvorfor er aggressiv tilstand mindre sikker?

Aggressiv tilstand er måske ikke så sikker som hovedtilstand, men fordelen ved aggressiv tilstand er, at den er hurtigere end hovedtilstand (da færre pakker udveksles). Aggressiv tilstand bruges typisk til VPN'er med fjernadgang. Men du ville også bruge aggressiv tilstand, hvis en eller begge peers har dynamiske eksterne IP-adresser