Indholdsfortegnelse:

Video: Hvad er collect PySpark?

2024 Forfatter: Lynn Donovan | [email protected]. Sidst ændret: 2023-12-15 23:45

Indsamle (Handling) - Returner alle elementer i datasættet som et array i driverprogrammet. Dette er normalt nyttigt efter et filter eller anden operation, der returnerer en tilstrækkelig lille delmængde af dataene.

På denne måde, hvad er PySpark?

PySpark Programmering. PySpark er et samarbejde mellem Apache Spark og Python. Apache Spark er en open source-klyngecomputerramme, bygget op omkring hastighed, brugervenlighed og streaminganalyse, hvorimod Python er et generelt programmeringssprog på højt niveau.

Hvad er kort i PySpark? Gnist Kort Transformation. EN kort er en transformationsoperation i Apache Spark. Det gælder for hvert element i RDD, og det returnerer resultatet som nyt RDD. Kort omdanner en RDD af længden N til en anden RDD af længden N. Input- og output-RDD'erne vil typisk have det samme antal poster.

På denne måde, hvad er SparkContext i PySpark?

PySpark - SparkContext . Annoncer. SparkContext er indgangen til evt gnist funktionalitet. Når vi kører evt Gnist applikation starter et driverprogram, som har hovedfunktionen og din SparkContext bliver sat i gang her. Driverprogrammet kører derefter operationerne inde i udførerne på arbejderknudepunkter.

Hvordan tjekker jeg PySpark-versionen?

2 svar

- Åbn Spark Shell Terminal og indtast kommandoen.

- sc.version Eller spark-submit --version.

- Den nemmeste måde er bare at starte "spark-shell" på kommandolinjen. Det vil vise.

- nuværende aktive version af Spark.

Anbefalede:

Hvad er w3c, hvad er Whatwg?

Web Hypertext Application Technology Working Group (WHATWG) er et fællesskab af mennesker, der er interesseret i at udvikle HTML og relaterede teknologier. WHATWG blev grundlagt af personer fra Apple Inc., Mozilla Foundation og Opera Software, førende webbrowserleverandører, i 2004

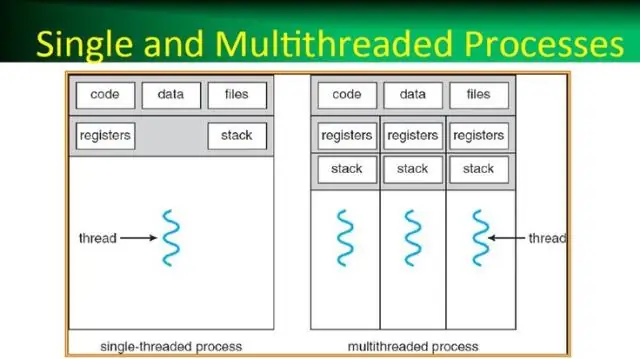

Hvad er en proces i et operativsystem hvad er en tråd i et operativsystem?

En proces er i de enkleste vendinger et eksekveringsprogram. En eller flere tråde kører i forbindelse med processen. En tråd er den grundlæggende enhed, som operativsystemet tildeler processortid til. Trådpoolen bruges primært til at reducere antallet af applikationstråde og give styring af arbejdstrådene

Hvad er cellehenvisning, og hvad er de forskellige typer referencer?

Der er to typer cellereferencer: relative og absolutte. Relative og absolutte referencer opfører sig anderledes, når de kopieres og udfyldes til andre celler. Relative referencer ændres, når en formel kopieres til en anden celle. Absolutte referencer forbliver på den anden side konstante, uanset hvor de kopieres

Hvordan laver jeg en PySpark DataFrame fra en liste?

Jeg følger disse trin for at oprette en DataFrame fra listen over tupler: Opret en liste over tupler. Hver tupel indeholder navn på en person med alder. Opret en RDD fra listen ovenfor. Konverter hver tupel til en række. Opret en DataFrame ved at anvende createDataFrame på RDD ved hjælp af sqlContext

Hvad er række i PySpark?

En række i SchemaRDD. Felterne i den kan tilgås som attributter. Række kan bruges til at oprette et rækkeobjekt ved at bruge navngivne argumenter, felterne vil blive sorteret efter navne